Alle Ergebnisse

Inhalt

Fakten

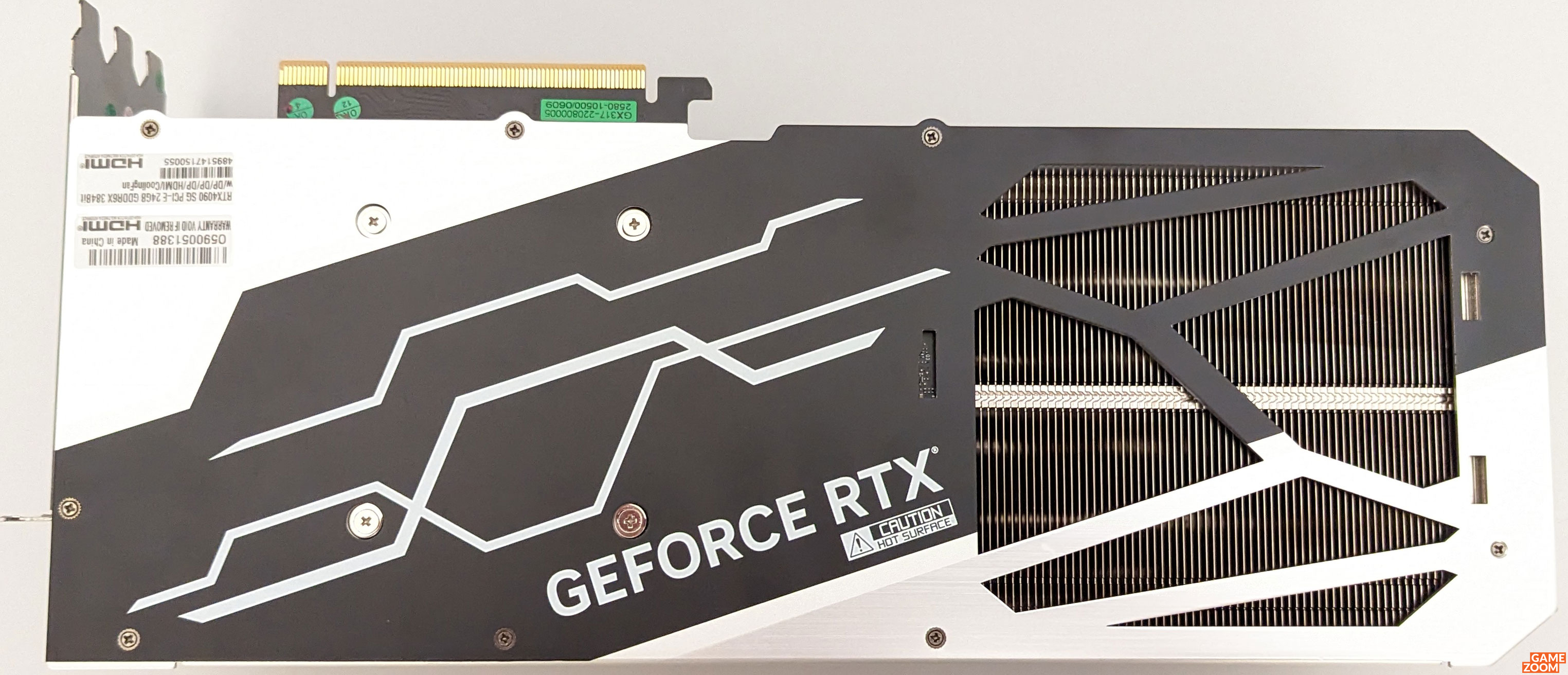

Hersteller

KFA2

Release

Dezember 2022

Produkt

Grafikkarte

Preis

ab 2099 Euro

Webseite

Media (15)

Galerie

Inhalt

Ähnliche Artikel

Kommentar schreiben